在AI驱动的图像创作领域,ComfyUI凭借其强大且多功能的基于节点的界面脱颖而出。当与Flux Outpainting结合使用时,它提供了一种卓越的方法来扩展图像的边界,无缝生成超出原始框架的内容。本文提供了详细的SEO优化指南,教你如何利用ComfyUI与Flux Outpainting实现令人惊叹的图像扩展。

关键点

- 了解ComfyUI基于节点的工作流程基础。

- 学习如何安装用于Outpainting的必要自定义节点。

- 掌握Flux Outpainting技术以扩展图像。

- 创建无缝图像扩展的工作流程。

- 自定义提示和设置以获得最佳效果。

- 解决常见的Outpainting问题。

ComfyUI与Flux Outpainting入门

什么是ComfyUI?

ComfyUI是一款基于节点的可视化编程工具,专为创建Stable Diffusion工作流程而设计。与传统界面不同,ComfyUI允许你通过连接单个处理节点来构建复杂的图像生成管道。这种模块化方法为图像创作的每一步提供了无与伦比的控制。基于节点的系统促进了实验和定制,使其成为高级用户和复杂图像处理任务的理想选择。ComfyUI的主要优势包括优化的性能、详细的控制以及精确复制工作流程的能力。对于希望突破AI艺术边界的人来说,这是一个绝佳的选择。许多专业的AI艺术生成器正在转向基于节点的实现,原因在于它解锁了更大的控制和更快的迭代开发。

ComfyUI的核心功能之一是能够加载检查点模型、CLIP模型和VAE。这一基础方面允许用户在UI中选择和组合不同的模型,以微调他们的图像生成工作流程。

检查点模型决定了生成图像的整体风格和主题,而CLIP模型处理文本编码和提示解释。VAE(变分自编码器)在编码和解码潜在空间中发挥着关键作用,提高了图像质量和连贯性。

- 检查点模型:决定整体风格(例如,写实、动漫、绘画)。常见的检查点模型包括Realistic Vision、Deliberate和AnythingV3。

- CLIP模型:编码文本提示,指导扩散过程。对于解释文本指令至关重要。

- VAE:增强图像质量并减少伪影。用于在潜在空间和像素空间之间进行转换。

Flux Outpainting简介

Outpainting是指通过算法生成新内容来扩展现有图像超出其原始边界的过程。Flux Outpainting是ComfyUI中的一种特定技术,利用自定义节点来实现这一点。它与传统的Inpainting不同,后者专注于填充图像内的缺失或损坏区域。Outpainting扩展了视觉叙事,通过添加上下文和细节来创建更大、更具沉浸感的场景。该技术在生成无缝纹理、创建全景视图或简单地扩展视觉上引人注目的图像范围等应用中非常有价值。

在ComfyUI中使用Flux Outpainting需要特定的设置,包括自定义节点和定义良好的工作流程。这些节点实现了必要的图像操作和生成过程,将你的初始图像作为起点,并根据指定的提示和设置生成连贯的扩展。通过精心设计工作流程和提示,你可以在原始图像和新生成的内容之间创建无缝过渡。

- 无缝纹理:为3D模型或背景创建重复图案。

- 全景视图:扩展风景图像以捕捉更宽的视野。

- 场景扩展:为现有场景添加额外的上下文或元素。

安装ComfyUI管理器及必要自定义节点

在深入工作流程之前,安装ComfyUI管理器至关重要。ComfyUI管理器是一个自定义节点,类似于ComfyUI中的插件商店。它简化了发现、安装和更新自定义节点的过程。没有它,安装和管理自定义节点可能会变得繁琐且容易出错。安装过程通常很简单,涉及将ComfyUI管理器仓库克隆到你的ComfyUI自定义节点目录中。

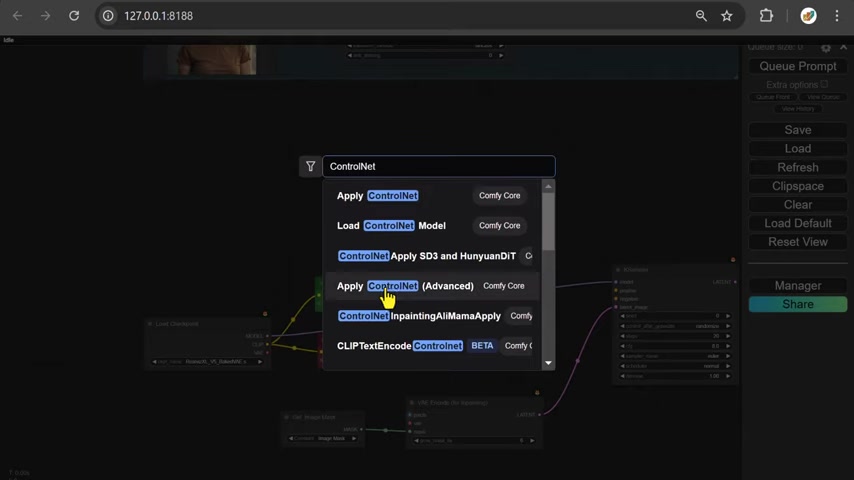

一旦安装了ComfyUI管理器,你可以轻松地从ComfyUI界面搜索并安装必要的自定义节点。一些用于Flux Outpainting的必备自定义节点包括:

- ComfyUI Layer Style:该节点套件允许进行高级图像混合和分层,实现Outpainted部分与原始图像的无缝集成。

- WAS Node Suite:该套件包含广泛的图像处理节点,包括用于图像操作、缩放和遮罩的节点。这些节点对于准备初始图像和混合Outpainted部分至关重要。

- Use Everywhere (UE) Nodes:这些节点创建全局变量,并允许你将数据“广播”到所有断开的输入。它大大减少了“意大利面条式布线”,并使复杂的工作流程更易于理解。

- KJNodes for ComfyUI:该节点包包括用于图像缩放和颜色操作的实用程序,进一步增强了最终输出的质量和连贯性。

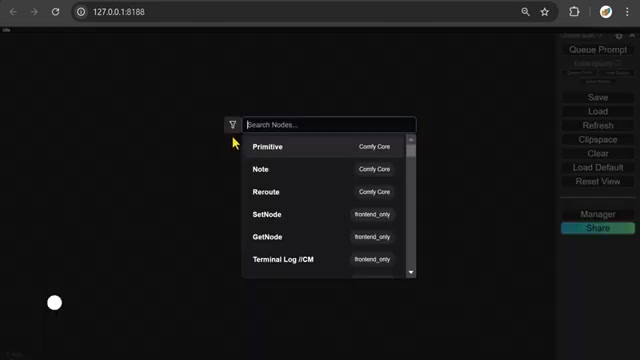

安装这些节点的步骤如下:

- 打开ComfyUI并导航到ComfyUI管理器。

- 搜索所需的节点套件。

- 点击每个节点套件旁边的“安装”。

- 重启ComfyUI以激活已安装的节点。

在ComfyUI中创建Flux Outpainting工作流程

设置核心节点

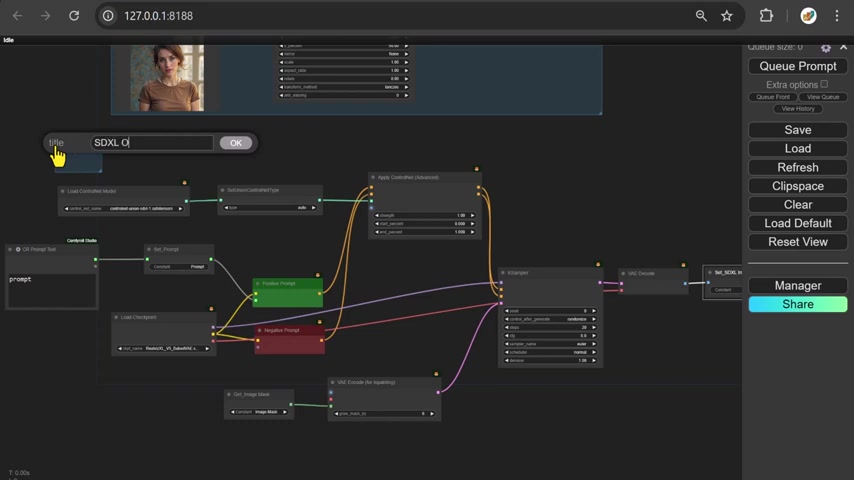

你的Flux Outpainting工作流程的基础涉及几个相互连接的节点,这些节点执行特定功能。这些节点按顺序工作,以准备图像、生成Outpainted部分并无缝地混合所有内容。

- 加载图像:首先加载你打算扩展的图像。该节点将你的起始图像导入ComfyUI工作流程。

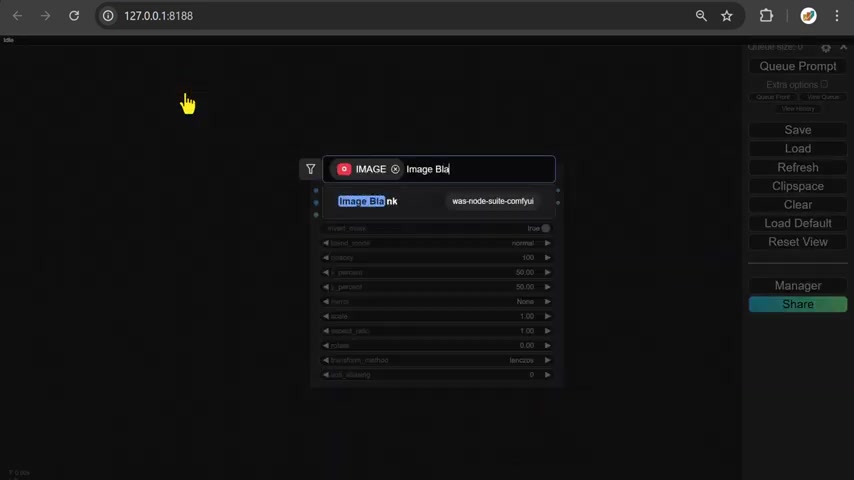

- 图像空白(WAS Node Suite):该节点创建一个空白图像画布,它将作为你原始图像的扩展背景。重要的是将其宽度和高度设置为略大于你的源图像。这为AI生成的新图像部分提供了画布。

- LayerUtility ImageBlendAdvance V2:来自ComfyUI Layer Style Suite的高级图像混合节点对于组合基础图像和空白图像至关重要。连接原始图像和空白图像,将混合模式设置为“normal”。启用“Invert Mask”选项。

- Anything Everywhere (UE) Nodes:这是使整个工作流程运转的节点。将图像连接到“Anything Everywhere”节点,以便提示的其他部分稍后可以调用它。

- 反转遮罩(Comfy Core):你需要反转遮罩,以便只绘制图像的外边缘。

- 设置图像遮罩(Comfy Core):这是你需要从输入图像部分安装的最后一个节点。图像和遮罩现在已经组合在一起。

设置ControlNet

ControlNet在引导AI生成过程中起着关键作用,确保新创建的内容与现有图像保持一致。通过使用ControlNet,你可以保持风格、构图和整体连贯性的一致性。设置ControlNet涉及以下几个步骤:

- 加载ControlNet模型:该节点加载ControlNet模型,该模型将指导生成。常见的ControlNet模型包括用于边缘检测的“control_sd15_canny”或用于面部特征对齐的“control_v11f1p_sd15_人像”。加载检查点还会加载CLIP模型和VAE模型。

- CLIP文本编码(提示):这是你发挥创造力的地方。创建两个这样的节点,分别用于正向提示和负向提示。该CLIP文本编码节点对于定义你希望添加到图像中的内容至关重要,为AI提供上下文指令。

- 正向和负向提示:这些文本提示指导图像生成过程。使用正向提示来描述你希望在生成内容中看到的内容,使用负向提示来指定要避免的内容。例如,正向提示可能是“房间里的女人”,而负向提示可能是“扭曲的脸,糟糕的解剖结构”。这一步塑造了Outpainting的艺术方向。

- 应用ControlNet(高级):该高级节点促进图像编码。将正向提示、负向提示和图像输入到节点中。这里的图像是带有遮罩的图像。现在可以设置开始百分比、结束百分比和CNET强度。

- Anything Everywhere3?:这是第一个对图片有直接影响的节点。它将带你回到原始提示。

确保ControlNet模型已正确加载和连接。适当的参数化是实现最佳结果的关键。尝试不同的ControlNet模型和设置,以微调生成的内容,使其符合你的愿景。

使用KSampler完成Outpainting工作流程

KSampler节点作为生成最终Outpainted图像的引擎。通过微调其参数,你可以控制输出的细节水平、风格和整体质量。

- KSampler:该节点执行实际的Stable Diffusion过程。将其连接到VAE解码节点、CLIP模型和ControlNet以生成扩展图像。确保在继续之前已加载检查点模型。

- VAE编码(用于Inpainting):这是用于Outpainting的VAE编码节点。你需要设置“pixel”和“mask by”,以及其他必要的参数,以查看加载到工作流程中的图片。

- 潜在图像:来自KSampler节点的“samples”连接器进入“latent”。“get image mask_mask, by”一直运行到VAE编码器的“mask”用于Inpainting。

- 设置潜在噪声遮罩:设置潜在样本,并遮罩VAE。

- 连接引导到KSampler:这建立了主循环。将种子设置为“fixed”,并将所有其他设置设置为较低范围,例如“steps”、“CFG”、“denoise”。

分步指南:创建Flux Outpainting工作流程

- 安装所需节点:确保已安装ComfyUI管理器、ComfyUI Layer Style、WAS Node Suite、Use Everywhere (UE) Nodes和KJNodes for ComfyUI。

- 设置图像和遮罩:加载图像并创建空白画布,确保ImageBlank的宽度和高度大于你的图像。将你的图像和空白连接到ImageBlendAdvance V2并反转遮罩。

- 提示和ControlNet设置:加载ControlNet模型,加载CLIP文本编码(提示)并在相应的框中输入提示。将正向和负向提示连接到高级ControlNet节点。

- 连接KSampler:将其全部连接到KSampler节点,并调整所有设置,包括样本、调度程序、名称、模型,以启动AI生成过程。

- VAE编码设置:这应该编码VAE用于Outpainting。它具有像素并需要被遮罩。

- 完成工作流程:你需要从这里设置并加载所有内容,然后图片才能正确组合。当你准备好时,点击“Queue Prompt”。

优缺点

👍 优点

- 无与伦比的定制:基于节点的工作流程提供了精细的控制。

- 优化的性能:ComfyUI设计用于高效的资源利用。

- 无缝图像扩展:Flux Outpainting提供了连贯且上下文感知的结果。

👎 缺点

- 陡峭的学习曲线:需要理解Stable Diffusion和ComfyUI的概念。

- 复杂的工作流程设置:构建Outpainting工作流程可能耗时。

- 依赖自定义节点:需要依赖外部节点套件。

常见问题解答

使用ComfyUI相比其他Stable Diffusion界面有什么优势?

ComfyUI的基于节点的系统提供了无与伦比的控制和定制,允许你精确定义图像生成过程的每一步。它还为高级用户进行了性能优化。

使用Flux Outpainting是否需要强大的GPU?

虽然推荐使用强大的GPU以加快处理速度,但ComfyUI也可以在低端GPU上运行,通过优化设置。考虑使用较小的图像尺寸和较低的样本计数以减少GPU负载。

如何解决常见的Outpainting问题,如接缝或风格不一致?

确保你的提示经过精心设计,并且ControlNet已正确配置以指导生成。尝试不同的混合模式和遮罩技术,以实现无缝过渡。

相关问题

除了Flux,还有其他方法可以实现Outpainting吗?

是的,其他技术包括使用带有生成填充工具的传统图像编辑软件或其他AI驱动的Outpainting服务。然而,ComfyUI与Flux提供了高度的定制和控制,这可能对高级用户更有利。

如何提高Outpainted图像的真实感和连贯性?

专注于制作详细且描述性的提示。使用ControlNet保持一致的风格、构图和照明。此外,尝试各种VAE以增强图像质量。

我可以自动化Flux Outpainting过程以处理多张图像吗?

是的,你可以设计你的ComfyUI工作流程,通过利用循环和脚本节点批量处理多张图像。这允许高效地对整个数据集进行Outpainting。

相关文章