在数字时代,技术进步为我们带来了前所未有的便利,但也伴随着新的安全挑战。AI语音克隆技术的兴起,使得诈骗手段日益逼真且难以辨别。想象一下,深夜接到一通电话,电话那头传来你女儿的哭诉声,恳求你的帮助。然而,你所听到的声音,看到的来电显示,都可能是精心设计的骗局。本文将深入探讨AI语音克隆诈骗的运作方式,以及如何保护自己和亲人免受其害。我们将分析诈骗的三个关键阶段,提供识别诈骗迹象的线索,并分享有效的防御策略。美国联邦调查局(FBI)已经发出了相关警告,因此,了解这些信息至关重要。本文旨在提高公众对AI诈骗的认识,并提供实用的防范措施。无论您是个人还是企业主,了解这些信息都至关重要,以保护您的财产、安全和内心的平静。请务必阅读完全文,做好准备,防患于未然!

AI语音克隆诈骗的关键要点

- 了解AI语音克隆的原理:理解AI如何模仿和复制声音。

- 识别诈骗迹象:学习如何发现潜在的诈骗电话和信息。

- 实施防御措施:采取积极措施保护个人和企业免受侵害。

- 重视隐私设置:定期审查和调整社交媒体及其他在线账户的隐私设置。

- 保持警惕:对未经证实的紧急求助保持怀疑态度。

AI语音克隆诈骗:新时代的数字威胁

FBI的警告:AI驱动的诈骗威胁日益增长。美国联邦调查局(FBI)已经发布了一项警告,强调网络犯罪分子正在越来越多地利用人工智能(AI)进行复杂的网络钓鱼和社会工程攻击,并进行声音克隆诈骗。FBI敦促个人和企业保持警惕,认识到这些骗局可能造成的毁灭性财务损失和声誉损害。

AI诈骗利用AI提供增强的规模化诈骗和攻击,自动化工具正在被网络罪犯利用,以精心策划高针对性的网络钓鱼活动,剥削个人和组织。这些AI驱动的网络钓鱼攻击的特点是,它们具有制作令人信服的虚假信息,巧妙地模仿声音和文字,从而大大提高了成功欺骗的可能。攻击者正在利用AI生成高度逼真的语音和视频消息,冒充受信任的个人和企业。这种策略会导致毁灭性的财务损失、声誉损害和妥协的敏感信息。FBI敦促个人和企业减轻与AI相关的网络钓鱼和声音克隆风险,方法是:保持警惕,注意未经请求的紧急信息,要求提供金钱或凭证。探索各种技术解决方案,以减少通过常规员工教育和员工对网络钓鱼和社会工程攻击的危险的认识来组合电话、社交工程电子邮件和短信的可能性。实施多因素身份验证,以提供额外的安全保障,防止未经授权的访问到帐户和系统。实施一种策略,要求那些请求敏感信息或财务交易的数字通信的身份验证。这些诈骗对每个人都构成了威胁,因此我们需要了解它们是如何运作的,以及如何保护自己。

设想情景:一个深夜来电

想象一下,在一个安静的夜晚,你已经沉沉睡去。突然,你的手机铃声打破了宁静。你迷迷糊糊地拿起手机,屏幕上显示的是你女儿的号码。

你瞬间清醒,心跳加速。这么晚了,她为什么会打电话来?难道出了什么事?你接起电话,女儿的声音带着哭腔,听起来惊恐万分:“爸爸/妈妈,我遇到麻烦了,请你救我!”你的心一下子提到了嗓子眼,所有的保护欲瞬间被激发。你焦急地询问发生了什么事,女儿却语焉不详,只是一味地恳求你的帮助。在这种情况下,你会怎么做?大多数父母都会毫不犹豫地伸出援手,哪怕这意味着付出巨大的代价。然而,这正是诈骗分子所期望的反应。他们利用父母对子女的爱和保护,精心设计骗局,让你在慌乱中失去判断力,最终落入陷阱。FBI警告说,罪犯正在利用人工智能来创造深度伪造和克隆声音,欺骗普通民众,每次诈骗都骗走数万美元。但如果电话里的声音不是你女儿的呢?如果屏幕上显示的是你女儿的号码,但实际上这通电话并不是从她的手机发出的呢?这就是AI语音克隆诈骗的可怕之处。它利用技术手段,模仿你亲人的声音,让你难辨真假,从而实施诈骗。

AI诈骗的惊人数字

为了让大家更清晰地认识到AI诈骗的严重性,我们来看一组数据:2023年,AI驱动的诈骗给美国人造成了超过1亿美元的损失。

每次诈骗的平均损失超过14000美元。全球范围内,诈骗造成的损失超过1万亿美元。这些数字不仅仅是冷冰冰的统计,它们代表着无数家庭的储蓄被洗劫一空,人们的安全感和内心的平静被彻底摧毁。AI诈骗正在对人们的生活造成真实而深远的影响,我们必须采取行动,阻止这种趋势蔓延。正如视频中所强调的,我们每个人都可能成为AI诈骗的受害者。那些认为自己“不值得”被骗的人,往往更容易成为目标,因为他们缺乏防范意识。因此,提高警惕,了解诈骗手段,掌握防范技巧,是我们保护自己的关键。

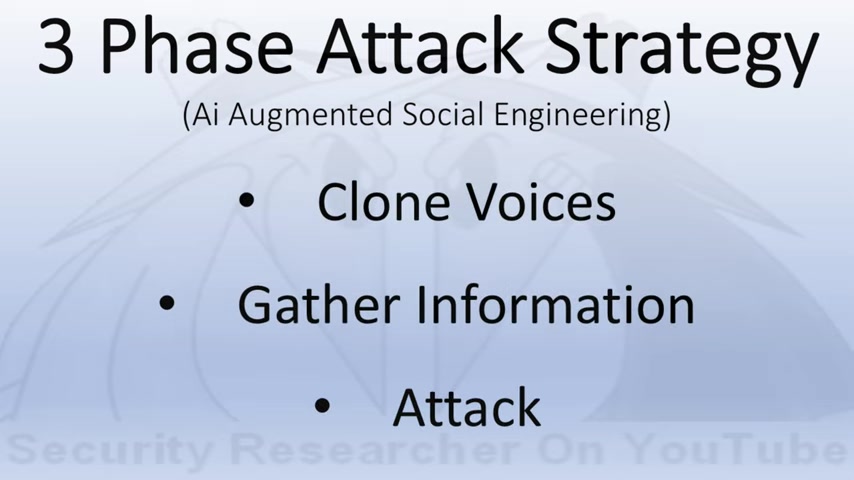

AI增强型社会工程攻击:三阶段策略分析

第一阶段:数据收集

社会工程攻击的第一步是数据收集。攻击者收集关于受害者的公开信息,包括他们的声音样本、社交媒体帖子、家庭联系方式和生活方式。这些信息可以从社交媒体、公司网站和其他公共来源获得。攻击者的目标是创建一个详细的画像,以便更好地定位受害者。数据收集是AI驱动社会工程攻击的基础。攻击者会利用各种手段,尽可能多地收集关于你的信息。这些信息可能包括你的声音样本、社交媒体帖子、家庭成员信息、工作单位信息等等。他们会像拼图一样,将这些碎片化的信息拼凑起来,形成你的完整画像,从而找到最有效的攻击方式。

- 声音样本:攻击者可能会从你的社交媒体视频、公开演讲录音或电话录音中提取你的声音样本。这些样本将被用于AI语音克隆,模仿你的声音进行诈骗。

- 个人信息:攻击者会仔细研究你的社交媒体,了解你的兴趣爱好、家庭成员、工作经历等等。这些信息将被用于定制诈骗内容,让你更容易上当受骗。

- 联系方式:攻击者会尽可能多地收集你的联系方式,包括电话号码、电子邮件地址、社交媒体账号等等。这将为他们提供多种渠道来接近你。

第二阶段:语音克隆与深度伪造生成

收集到足够的数据后,攻击者就开始利用AI技术进行语音克隆和深度伪造。他们会使用你的声音样本,训练AI模型,使其能够模仿你的声音,甚至可以模仿你的语气和情感。攻击者会利用这些信息创建高度逼真的AI语音和AI视频,这些将会在第三阶段中被用于增强诈骗的可信度。

- 语音克隆:攻击者利用AI技术,模仿你的声音,让你在电话中难以辨别真假。他们甚至可以模仿你的语气和情感,让你更加信任他们。

- 深度伪造视频:攻击者利用AI技术,将你的脸部移植到别人的视频中,或者修改视频内容,让你说出或做出你从未说过或做过的事情。这种技术被广泛用于制造虚假信息和诽谤。

第三阶段:攻击

准备工作完成后,攻击者就开始实施最终的攻击。他们可能会给你打电话,冒充你的亲友,声称遇到了紧急情况,需要你的帮助。由于他们已经掌握了你的个人信息和声音,你很可能信以为真,从而落入他们的圈套。

- 紧急求助:攻击者会制造紧急情况,让你在慌乱中失去判断力。他们可能会声称你的亲友遭遇了车祸、被绑架或被逮捕,需要你立即汇款。

- 情感操控:攻击者会利用你的同情心和爱心,让你心甘情愿地付出。他们可能会声称你的亲友身患重病,需要你的捐款。

- 施加压力:攻击者会不断催促你,让你没有时间思考和核实。他们可能会声称时间紧迫,如果不能及时汇款,你的亲友就会有生命危险。

识别AI诈骗的关键线索

识别AI生成语音的技巧

尽管AI语音克隆技术日趋成熟,但目前仍存在一些可以识别的迹象。以下是一些需要注意的线索:

- 声音的不一致性:注意声音的音调、音高是否存在突然变化,或者声音是否听起来不自然或不真实。

- 缺乏熟悉的话语模式:注意克隆的语音是否缺乏你通常所期望的表达习惯或口头禅,这可能表明它不是真正的声音。

- 细微的扭曲:注意语音中是否有细微的扭曲或机械感,这可能表明该语音是合成的。

- 缺乏情感深度:由于AI难以完全复制人类的情感,因此要注意语音中是否缺乏情感上的细微差别或真实的反应。

如何识别深度伪造视频

深度伪造视频是利用AI创建的虚假视频,可以逼真地模仿人物的面部表情和声音。以下是一些可以帮助识别深度伪造视频的线索:

- 面部表情和真实感的缺失:注意视频中人物的面部表情是否僵硬或不自然,缺乏真实的情感表达。

- 面部形状和比例:检查视频中人物的面部形状和比例是否与已知图像一致,不匹配可能表明存在篡改。

- 眼睛:观察眼睛的注视方向和眨眼模式是否不自然。

- 侧面角度:侧面角度的面部深度伪造技术通常较弱,可能会出现扭曲或不清晰。

- 皮肤:被操纵过的面部可能呈现出蜡像般的质感,缺乏自然皮肤的纹理和瑕疵。

AI社工诈骗的价格

AI工具价格和社工诈骗的关系。社工攻击与诈骗,AI技术的运用加深了其影响。了解不同AI工具的价格,以及如何善用科技来保护自己。以下提供关于AI社工诈骗的价格范例:

| AI工具 | 价格区间 (每月) | 用途 |

|---|---|---|

| 声音复制软件 | $29 - $199 | 复制特定人士的声音,用于电话诈骗或假消息散布。 |

| 深度伪造影片生成器 | $49 - $299 | 制作逼真的假影片,用于勒索或名誉损害。 |

| 社交媒体数据分析工具 | $99 - $499 | 分析目标对象的社交媒体活动,用于精准营销或个性化诈骗。 |

| 自动讯息生成器 | $19 - $99 | 大量生成诈骗邮件或讯息,提高诈骗成功率。 |

请注意,这些价格仅供参考,实际价格可能因供应商和功能而异。

AI语音克隆诈骗:机遇与挑战

优点

- 自动化诈骗:大幅提高诈骗效率。

- 降低人力成本:减少诈骗团伙的人员需求。

- 欺骗性更强:克隆的声音难以辨别,更容易让人上当。

缺点

- 技术门槛提高:需要一定的AI技术才能实现。

- 法律风险:克隆他人声音可能触犯法律。

- 道德争议:利用AI进行诈骗违背伦理道德。

常见问题解答

什么是AI语音克隆诈骗?

AI语音克隆诈骗是指诈骗分子利用人工智能技术,模仿目标人物的声音,然后冒充该人与受害者进行联系,实施诈骗。这种诈骗手段往往难以辨别,因为克隆的声音与真人的声音几乎完全一致。

我该如何识别AI诈骗电话?

识别AI诈骗电话的关键在于保持警惕。注意声音是否不自然、是否存在不熟悉的措辞、是否存在不合逻辑的请求等。如果你对来电者的身份有任何怀疑,请立即挂断电话,并尝试通过其他渠道与该人联系。

我该如何保护自己免受AI诈骗?

保护自己免受AI诈骗需要采取多重措施。首先,要提高安全意识,了解AI诈骗的常见手段。其次,要保护个人信息,避免在社交媒体上分享过多敏感信息。第三,要使用多因素身份验证,提高账户的安全性。最后,要保持警惕,对任何未经证实的紧急求助保持怀疑态度。

相关问题

除了语音克隆,AI还能用于哪些类型的诈骗?

AI除了可以用于语音克隆诈骗外,还可以用于以下类型的诈骗:深度伪造视频诈骗:攻击者使用AI生成虚假的视频,冒充他人进行欺骗。自动化网络钓鱼:AI可以自动生成针对特定目标的钓鱼邮件,提高欺骗性。虚假身份:AI可生成逼真的人脸图像,用于创建虚假的社交媒体个人资料,或绕过人脸识别身份验证协议。这些只是AI诈骗的冰山一角,随着技术的不断发展,AI诈骗的手段也将越来越多样化。

相关文章