ComfyUI Inpainting 工作流详解:三种高级技术深度解析

在数字图像处理领域,inpainting 是一项关键技术,它允许我们无缝修复图像中的缺失或损坏区域。ComfyUI 作为一款强大的节点式图像生成工具,提供了灵活且高度可定制的 inpainting 工作流。本文将带你深入了解 ComfyUI 的 inpainting 功能,从基本概念到高级技巧,助你掌握图像修复的核心技能。我们将探讨三种不同的 ComfyUI inpainting 工作流,分别是:使用标准模型进行 inpainting、使用 inpainting 模型进行 inpainting 以及使用 ControlNet 进行 inpainting。每种方法都有其独特的优势和适用场景,掌握它们将使你能够应对各种复杂的图像修复任务。无论你是 AI 图像生成新手还是经验丰富的专业人士,本文都将为你提供宝贵的知识和实用的技巧,让你能够充分利用 ComfyUI 的 inpainting 功能,创造出令人惊叹的图像修复作品。让我们一起踏上 ComfyUI inpainting 的探索之旅吧!

ComfyUI Inpainting 关键要点

- Inpainting 的基本概念:了解什么是 inpainting 以及它在图像处理中的作用。

- ComfyUI inpainting 工作流:学习如何在 ComfyUI 中设置和使用 inpainting 功能。

- 标准模型 inpainting:掌握使用标准 Stable Diffusion 模型进行 inpainting 的方法。

- Inpainting 模型 inpainting:了解如何利用专门的 inpainting 模型来提高修复质量。

- ControlNet inpainting:探索使用 ControlNet 进行精确控制的 inpainting 技术。

- 不同工作流的比较:分析三种 inpainting 方法的优缺点和适用场景。

- 实战技巧:学习提升 inpainting 效果的实用技巧和参数调整方法。

ComfyUI Inpainting 工作流概述

什么是 Inpainting?

Inpainting,也称为图像修复,是一种利用图像现有信息来重建图像缺失或损坏部分的技术。它广泛应用于各种场景,例如:

- 去除图像瑕疵:修复照片中的划痕、污渍等。

- 移除不需要的物体:从照片中移除人物、标志等。

- 扩展图像内容:在图像边缘生成新的内容,例如扩展天空或背景。

- 修复老照片:恢复因时间流逝而褪色或损坏的老照片。

- 艺术创作:用于生成独特的艺术效果和创意图像。

ComfyUI 中的 Inpainting

ComfyUI 是一款基于节点式工作流的图像生成工具,它提供了高度的灵活性和可定制性。在 ComfyUI 中,inpainting 可以通过各种节点和模型的组合来实现。这种节点式的设计允许用户精确控制图像修复的每个步骤,从而获得最佳的修复效果。

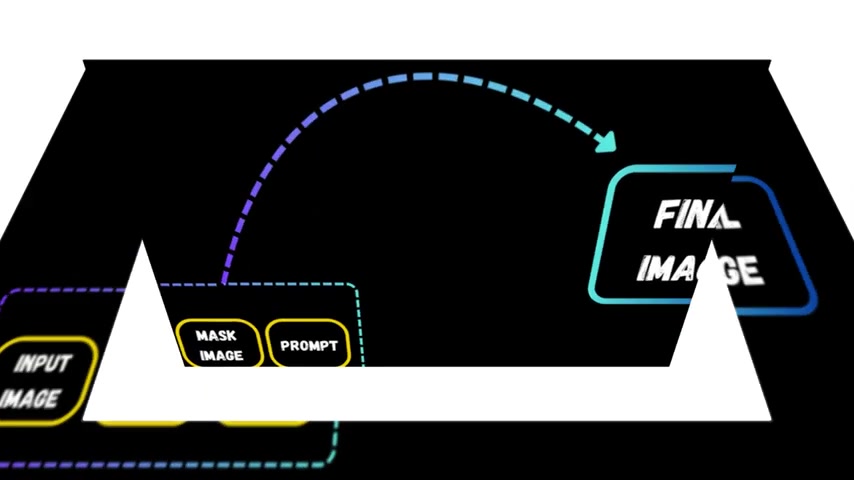

ComfyUI 的 inpainting 功能主要依赖于以下几个关键组件:

- VAE (Variational Autoencoder):用于将图像编码到潜在空间,并在潜在空间中进行操作。

- Stable Diffusion 模型:作为图像生成的核心引擎,负责根据提示词和掩码生成新的图像内容。

- 掩码 (Mask):用于指定需要修复的区域,ComfyUI 允许用户使用各种工具创建和编辑掩码。

- 提示词 (Prompt):用于引导 Stable Diffusion 模型生成期望的图像内容。

- ControlNet:一种强大的神经网络结构,可以对图像生成过程进行更精确的控制,例如控制图像的结构、边缘等。

通过组合这些组件,ComfyUI 能够实现各种复杂的 inpainting 任务,满足不同用户的需求。

ComfyUI Inpainting 三种高级工作流详解

工作流一:使用标准模型进行 Inpainting

这是最基本的 ComfyUI inpainting 工作流,它使用标准的 Stable Diffusion 模型进行图像修复。该方法简单易用,适用于对修复质量要求不高的场景。

工作流步骤:

- 加载图像和掩码:使用

Load Image节点加载需要修复的图像,并使用Load Image或其他节点加载与图像对应的掩码。 - VAE 编码:使用

VAE Encode节点将图像编码到潜在空间。这一步将原始图像转换为一种更紧凑、更易于操作的表示形式。 - 设置潜在噪声掩码:使用

Set Latent Noise Mask节点将掩码应用于潜在空间。该节点是进行 inpainting 的关键。它指示 AI 需要调整图像的哪些区域,并保持其他区域不变。 - K Sampler:使用

K Sampler节点,根据提示词和潜在噪声掩码生成新的图像内容。K Sampler是 Stable Diffusion 的核心采样器,负责从潜在空间生成最终图像。 - VAE 解码:使用

VAE Decode节点将潜在空间中的图像解码回像素空间,得到修复后的图像。 - 保存图像:使用

Save Image节点将修复后的图像保存到本地。

参数调整:

- 提示词:使用清晰、具体的提示词来引导 Stable Diffusion 模型生成期望的图像内容。

- 采样步数 (Steps):增加采样步数可以提高图像质量,但也会增加计算时间。

- CFG Scale:控制提示词的影响程度,较高的值会使图像更符合提示词,但可能会导致图像失真。

- Denoise:控制图像的去噪强度,较低的值可以保留更多原始图像的细节,较高的值可以生成更符合提示词的新内容。

注意事项:

- 该方法适用于对修复质量要求不高的场景,例如快速去除图像中的小瑕疵。

- 由于使用标准 Stable Diffusion 模型,修复后的图像可能会与原始图像存在一定的差异。

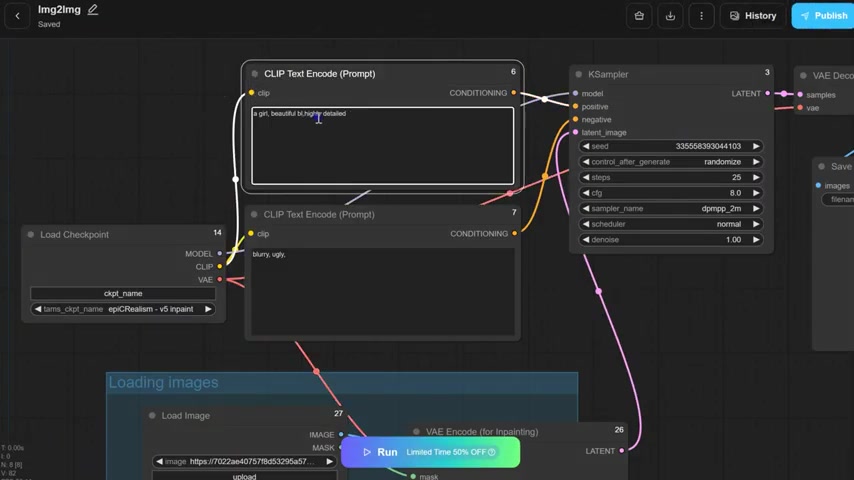

工作流二:使用 Inpainting 模型进行 Inpainting

为了提高 inpainting 的修复质量,我们可以使用专门针对 inpainting 任务训练的模型。这些模型通常具有更好的图像理解能力和更强的生成能力。

工作流步骤:

- 加载图像和掩码:与标准模型 inpainting 相同。

- VAE 编码(用于 Inpainting):使用

VAE Encode (for Inpainting)节点将图像编码到潜在空间。该节点专门针对 inpainting 任务进行了优化。 - K Sampler:使用

K Sampler节点,根据提示词和潜在空间表示生成新的图像内容。需要注意的是,这里需要使用针对 inpainting 任务训练的模型。 - VAE 解码:与标准模型 inpainting 相同。

- 保存图像:与标准模型 inpainting 相同。

参数调整:

- 与标准模型 inpainting 类似,但需要注意的是,不同的 inpainting 模型可能对参数的敏感度不同,需要根据实际情况进行调整。

- Denoise:将 Denoise 设置为 1。

注意事项:

- 该方法可以获得比标准模型 inpainting 更好的修复质量,尤其是在修复大面积缺失区域时。

- 需要选择合适的 inpainting 模型,不同的模型可能适用于不同的图像类型和修复任务。

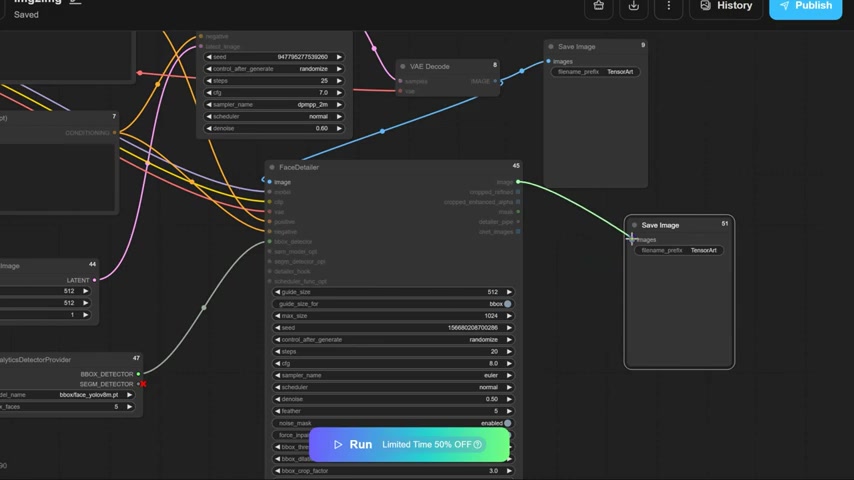

工作流三:使用 ControlNet 进行 Inpainting

ControlNet 是一种强大的神经网络结构,可以对图像生成过程进行更精确的控制。通过结合 ControlNet 和 inpainting 技术,我们可以实现对图像修复过程的精细化控制,例如控制修复区域的结构、边缘等。

工作流步骤:

- 加载图像和掩码:与标准模型 inpainting 相同。

- 加载 ControlNet 模型:使用

Load ControlNet Model节点加载 ControlNet 模型。需要选择与 inpainting 任务相关的 ControlNet 模型,例如 Canny 边缘检测模型。 - Inpaint Preprocessor:使用

Inpaint Preprocessor节点。此节点同时处理像素图像和 inpaint 掩码。 - 应用 ControlNet:使用

Apply ControlNet节点将 ControlNet 模型应用于图像生成过程。该节点将 ControlNet 模型的输出与 Stable Diffusion 模型的潜在空间表示相结合,从而实现对图像生成过程的控制。 - VAE 编码:与标准模型 inpainting 相同。

- K Sampler:使用

K Sampler节点,根据提示词、潜在空间表示和 ControlNet 模型的输出生成新的图像内容。 - VAE 解码:与标准模型 inpainting 相同。

- 保存图像:与标准模型 inpainting 相同。

参数调整:

- 与标准模型 inpainting 类似,但需要注意的是,ControlNet 模型的参数也需要根据实际情况进行调整。

- ControlNet 强度 (Strength):控制 ControlNet 模型的影响程度,较高的值会使图像更符合 ControlNet 模型的输出,但可能会导致图像失真。

注意事项:

- 该方法可以实现对图像修复过程的精细化控制,例如控制修复区域的结构、边缘等。

- 需要选择合适的 ControlNet 模型,不同的模型可能适用于不同的图像类型和修复任务。

- ControlNet inpainting 的设置相对复杂,需要一定的经验和技巧。

详细使用步骤

准备工作

- 安装 ComfyUI:确保你已经成功安装了 ComfyUI,并且可以正常运行。

- 下载模型:根据你选择的 inpainting 工作流,下载所需的 Stable Diffusion 模型、inpainting 模型和 ControlNet 模型。

- 安装 ComfyUI 插件:某些高级节点可能需要安装额外的 ComfyUI 插件。你可以使用 ComfyUI Manager 插件来方便地安装和管理插件。

标准模型 Inpainting

准备图片和蒙版

- 加载图片:双击加载图片节点,选择需要修复的图片。

- 设置蒙版:右键点击加载图片节点,选择“在蒙版编辑器中打开”,涂抹需要修复的区域。

- 设置提示词:在“CLIP文本编码”节点中,输入正向提示词,描述你希望修复区域生成的内容,同时可以输入负向提示词。

配置采样器

- Seed: 随机种子用于控制生成结果的可重复性

- Steps: 采样步数,决定图像生成的质量,通常20-30步就足够了

- CFG Scale: 分类器引导比例,引导AI生成图像的强度, 通常8-12即可

- Denoise: 降噪参数控制应用于图像的降噪程度,较低的值适用于细微调整,而较高的值适用于更大胆的更改。

运行与保存

- 运行:点击“执行队列”按钮开始生成。

- 保存图片:点击”储存图片“节点,将图像保存到本地。

Inpainting 模型 Inpainting

- 加载图像和蒙版:和标准模型 Inpainting 准备工作一样。

- 使用 Inpainting VAE:移除标准 VAE 编码器,添加

VAE Encode (for Inpainting),并将图片节点和蒙版节点连接。 - 选择 Inpainting 模型:从 checkpoint 选择 Inpainting 模型。

- 配置采样器:Inpainting 模型要求 denoise 设置为 1。其他参数和标准模型 Inpainting 相似。

- 运行和保存:按照标准模型 Inpainting 相同步骤。

ControlNet 模型 Inpainting

- 加载图像和蒙版:和标准模型 Inpainting 准备工作一样。

- 加载 ControlNet 模型:添加

Load ControlNet Model,并选择需要的 ControlNet 模型。 - 加载 Inpaint Preprocessor:添加

Inpaint Preprocessor,并将图像节点和蒙版节点连接至此。 - 连接 ControlNet:添加

Apply ControlNet将 control_net 连接。 - 配置采样器:除了要设置提示词外,还需要设置 ControlNet 强度。

- 运行和保存:按照标准模型 Inpainting 相同步骤。

ComfyUI Inpainting 的成本

ComfyUI 本身是免费的。ComfyUI 是一款开源软件,你可以免费下载和使用它。这意味着你不需要支付任何许可费用或订阅费用。但是,使用 ComfyUI 进行 inpainting 可能会产生一些间接成本:

- 硬件成本:ComfyUI 依赖于强大的计算硬件,尤其是 GPU。如果你没有高性能的 GPU,可能需要购买或租用云服务器。

- 模型成本:虽然有很多免费的 Stable Diffusion 模型、inpainting 模型和 ControlNet 模型可以使用,但一些高质量的模型可能需要付费购买。

- 时间成本:学习和掌握 ComfyUI inpainting 需要一定的时间和精力。你需要花时间阅读文档、观看教程、进行实验等。

ComfyUI Inpainting 的优缺点

优点

- 高度可定制的工作流

- 精细化的控制能力

- 强大的社区支持

- 开源和免费

缺点

- 学习曲线较陡峭

- 需要一定的技术基础

- 节点式界面可能对新手不友好

ComfyUI Inpainting 的核心特性

- 高度可定制的工作流:ComfyUI 允许用户自由组合各种节点,构建高度定制化的 inpainting 工作流。你可以根据自己的需求选择不同的模型、采样器、ControlNet 模型等,从而获得最佳的修复效果。

- 精细化的控制能力:通过 ControlNet 等技术,ComfyUI 提供了对图像生成过程的精细化控制能力。你可以控制修复区域的结构、边缘、颜色等,从而实现更逼真的修复效果。

- 强大的社区支持:ComfyUI 拥有一个活跃的社区,用户可以在社区中分享工作流、模型、插件等。你可以从社区中获取灵感和帮助,快速解决遇到的问题。

- 开源和免费:ComfyUI 是一款开源软件,你可以免费下载和使用它。这意味着你不需要支付任何许可费用或订阅费用。

ComfyUI Inpainting 的应用场景

- 图像修复:ComfyUI inpainting 可以用于修复各种类型的图像,例如照片、绘画、漫画等。它可以去除图像中的划痕、污渍、水印等,恢复图像的原始状态。

- 物体移除:ComfyUI inpainting 可以用于从图像中移除不需要的物体,例如人物、标志、建筑物等。这在商业摄影、广告设计等领域非常有用。

- 内容扩展:ComfyUI inpainting 可以用于扩展图像内容,例如扩展天空、背景、海洋等。这可以用于创建更具视觉冲击力的图像作品。

- 艺术创作:ComfyUI inpainting 可以用于生成独特的艺术效果和创意图像。你可以通过组合不同的模型、提示词和 ControlNet 模型,创造出令人惊叹的艺术作品。

常见问题解答

ComfyUI Inpainting 需要什么样的硬件配置?

ComfyUI Inpainting 依赖于强大的计算硬件,尤其是 GPU。建议使用具有 8GB 或以上显存的 GPU,以获得最佳的性能和效果。此外,还需要足够的内存和存储空间。

ComfyUI Inpainting 支持哪些模型?

ComfyUI Inpainting 支持各种 Stable Diffusion

相关文章