Google DeepMind 发布了 Gemma 3,这是一系列开放的 AI 模型,设计为超级轻量、灵活且易于在单个加速器上部署。基于 Gemini 系列的研究基础,Gemma 3 引入了先进的文本和视觉推理、广泛的语言支持以及大上下文窗口,标志着在可访问性和强大 AI 方面迈出了重要一步。

关键点

- Gemma 3 设计用于在单个加速器(如 GPU 或 TPU)上轻松部署。

- 它支持超过 140 种语言,使其具有全球可访问性。

- 其多模态能力使其能够处理图像、短视频和文本输入。

- 该模型利用了名为 SigLip 的视觉编码器技术,增强了视觉推理能力。

- Gemma 3 提供了大上下文窗口,可处理多达 128,000 个 token,适用于更复杂的任务。

- 有一个学术计划,为研究人员提供价值 10,000 美元的 Google Cloud 积分。

深入了解 Google 的 Gemma 3

什么是 Gemma 3?

Google DeepMind 的 Gemma 3 代表了一种新型的开放 AI 模型,专注于可访问性和效率。与更大、更耗资源的模型不同,Gemma 3 设计为轻量级且易于部署,使其非常适合在单个加速器上使用,无论是 GPU、TPU 还是 AMD GPU 或 Jetson Nano 等专用硬件。其目标是让更广泛的受众能够使用先进的 AI 能力,使开发者和研究人员能够在不需要大量基础设施的情况下利用尖端技术。Gemma 3 支持超过 140 种语言,并具有多模态能力,使其能够处理各种类型的输入,包括图像、短视频和文本。

Gemma 3 模型建立在与 Gemini 系列相同的研究基础上。然而,Gemma 3 特别专注于超级轻量、灵活且易于在单个加速器上部署。这是您可以在单个设备上运行的最强大模型。其主要亮点在于其先进的文本和视觉推理能力。Gemma 3 模型还具备先进的功能,如大上下文窗口,最多可处理 128,000 个 token。128,000 个 token 的上下文对于开放模型来说非常大,但最近我们看到它正在成为一种常态。

Gemma 3 的主要功能和能力

Gemma 3 在功能方面表现出色,提供了一系列旨在赋能开发者和研究人员的功能。以下是主要亮点的概述:

- 多模态输入:Gemma 3 不仅限于文本,还可以处理图像、短视频和文本。这种多功能性为 AI 驱动的应用程序打开了新的可能性,使其能够理解和响应各种输入。

- 广泛的语言支持:Gemma 3 内置支持超过 140 种语言,使其成为一个真正的全球 AI 模型,能够理解和生成多种语言环境下的内容。

- 大上下文窗口:Gemma 3 可处理多达 128,000 个 token 的大上下文窗口。这使得模型能够处理和理解长文档或对话,从而实现更全面和细致的交互。此功能也与 Gemma 3 模型实现的令人印象深刻的 ELO 分数有关。

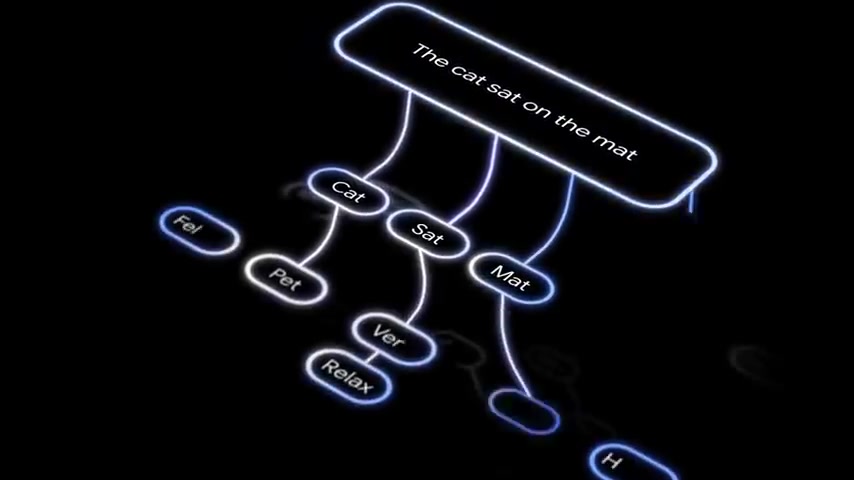

- SigLip 视觉编码器:Gemma 3 利用了名为 SigLip 的视觉编码器技术,该技术具有一个冻结的 4 亿参数视觉骨干,将图像转换为一系列 256 个视觉 token。这些 token 随后被输入到语言模型部分,使 Gemma 3 能够回答有关图片的问题、识别物体,甚至读取嵌入图像中的文本。

- 平移和扫描技术:为了确保非方形格式的图像能够正确处理,并正确解析其中的文本,使用了平移和扫描技巧。它将图像切割成较小的裁剪区域以保留细节。

Gemma 3 模型规模和性能

探索不同的 Gemma 3 模型规模

Gemma 3 发布了四种规模,以满足不同的需求和硬件能力:1B、4B、12B 和 27B 参数。“B”代表十亿参数。

| 模型 | 规模(参数) | 上下文长度 | 语言 | 输入模态 | 输出模态 | 硬件优化 |

|---|---|---|---|---|---|---|

| Gemma 3 1B (IT) | 1B | 32k | 英语 | 文本 | 文本 | 优化用于 CPU 执行 |

| Gemma 3 4B (IT) | 4B | 128k | 140+ | 文本、图像 | 文本 | 设计用于单个加速器 |

| Gemma 3 12B (IT) | 12B | 128k | 140+ | 文本、图像 | 文本 | 优化用于 NVIDIA GPU |

| Gemma 3 27B (IT) | 27B | 128k | 140+ | 文本、图像 | 文本 | 优化用于 Google Cloud TPU |

在聊天机器人竞技场评分中,Gemma 3 27B-IT 的 ELO 得分为 1,338,远高于 deepseek V3、O3 Mini 和 Llama 3 的 405B 会员版等老牌开放模型。ELO 分数清楚地表明,尽管 Gemma 3 27B 与庞大的 70B 或 400B 模型相比规模较小,但它在用户偏好方面表现非常出色。27B 版本在各种比较中都是明星。

Gemma 3 的架构创新

Gemma 3 引入了多项旨在提高效率和性能的架构创新。其中一个关键方面是注意力机制的方法。

Gemma 3 并没有完全依赖全局自注意力层,而是结合了局部和全局层。这种设计创建了大约 5:1 的分配。局部自注意力发生在五层,然后是一层全局注意力。模型使用了一系列局部自注意力层,中间穿插了较少的全局层。这大大减少了内存占用,因为并非所有层都需要处理整个 128k token。这些局部层使用 1,024 个 token 的滑动窗口。

为了解决大上下文窗口带来的内存开销,Gemma 3 采用了量化技术,即将所有 16 位浮点权重压缩为 int4 或某种特殊的 float8 表示,从而使模型适应更小的内存占用。这意味着您的 KV 缓存不会爆炸。通过量化感知训练和知识蒸馏的简短轮次,即使在使用较少比特的情况下,也能保持模型的准确性。此外,他们还推出了官方量化版本的 Gemma 3。对于在较小硬件上运行这些大型模型来说,这是一个巨大的优势,尤其是在某些情况下您想在 CPU 上托管它时。

这种方法显著减少了内存占用,因为并非所有层都需要处理整个上下文窗口。

Gemma 3 的实际应用

Gemma 3 的现实世界应用

Gemma 3 的多功能性使其适用于广泛的应用,从聊天机器人和虚拟助手到内容生成和数据分析。由于其在单个加速器上易于部署,Gemma 3 可以集成到现有系统中,而无需进行重大的硬件升级。以下是一些用例:

- 内容创作:Gemma 3 的文本生成能力可用于创建文章、博客文章和营销材料,简化内容创作工作流程。

- 数据分析:凭借其处理大量文本的能力,Gemma 3 可用于分析数据集、提取洞察和识别趋势,为决策提供有价值的支持。

- 教育工具:Gemma 3 可以为交互式学习平台提供动力,为学生提供个性化反馈和支持,增强他们的学习体验。

开发者在部署像 Gemma 3 这样的开放模型时需要负责任地处理安全问题。在硬件方面,官方表示 Gemma 3 已经针对 NVIDIA GPU、Google Cloud TPU、通过 ROCM 的 AMD GPU 以及使用 gemma.cpp 的 CPU 执行进行了优化。

访问 Gemma 3 和学术支持

访问模型

Gemma 3 可以从 Kaggle、Hugging Face 或 Ollama 免费下载。如果您喜欢 Hugging Face,您可以在那里找到 Gemma 3。如果您更喜欢 Jax、Keras、Pytorch 或 VLLM,您也有这些选项。他们还发布了用于训练和推理的新配方和代码库,因此如果您想进行自己的微调,您可以这样做。

Google DeepMind 为希望使用这些新模型进行严肃研究的学术研究人员提供价值 10,000 美元的 Google Cloud 积分。

Gemma 3 的优缺点

优点

- 轻量级设计,易于部署。

- 广泛的语言支持(140+ 种语言)。

- 多模态能力(文本、图像、视频)。

- 大上下文窗口(最多 128,000 个 token)。

- 开放 AI 模型,易于修改和定制。

- 为研究人员提供 10,000 美元 Google Cloud 积分的学术计划。

缺点

- 与更强大的模型(如 Gemini)相比,模型规模较小。

- 需要持续的安全措施以防止滥用。

- 仍然依赖于训练数据过滤以避免有害输出。

探索 Gemma 3 的核心功能

Gemma 3 提供了一套全面的功能,旨在赋能开发者和研究人员。Gemma 3 模型经过负责任地训练,这意味着他们尝试遵循风险比例方法。为了正确处理数据,使用了 1024 的滑动窗口。局部自注意力也被使用。由于某些任务在应用 PNS 后出现了大幅提升,这对于从图像中读取文本或处理复杂的宽高比非常有用,图像安全也是一个考虑因素。

该模型还支持函数调用和结构化输出,因此它可以原生生成 JSON 或运行函数签名,而无需使用 hacky 提示。他们还发布了用于训练和推理的新配方和代码库,因此如果人们想进行自己的微调,他们可以这样做。所有模型都推出了官方量化版本,并针对 NVIDIA 系统进行了优化。他们从 Jetson Nano 到顶级 Blackwell 芯片都有直接优化。它出现在 NVIDIA API 目录中,因此您可以从那里进行快速原型设计。

Gemma 3 的多样化用例

Gemma 3 在现实世界中有多种用途。如果您喜欢在本地机器上试用它,您可以从 Kaggle、Hugging Face 或 Ollama 下载权重。他们还强调,如果您想使用这些模型或他们的代码,您可以通过您喜欢的框架来实现。

一些例子包括 AI Singapore 的 Sea-Lion V3 和 Nexa AI 的 OmniAudio,其中 Gemma 模型的开放性使人们能够构建从语言翻译到高级音频处理的非常专业的衍生模型。

AI Singapore 的 Sea-Lion V3 是一组开源的大型语言模型,设计有三个关键目标:赋能下一代研究人员和工程师,紧凑且高性能,理解东南亚(SEA)语言和文化。

Nexa AI 的 Omniaudio 是一项专门服务,旨在以令人印象深刻的准确性处理实时音频转录。它支持多种语言的实时转录,包括英语、西班牙语、德语、法语、意大利语和葡萄牙语。其现实世界用途包括分析口语内容、生成元数据,以及通过 API 端点与其他应用程序无缝集成。

关于 Gemma 3 的常见问题

Gemma 3 与其他 AI 模型相比的主要优势是什么?

Gemma 3 的主要优势包括其轻量级设计、易于部署、多模态能力、广泛的语言支持和大上下文窗口。它在性能和可访问性之间提供了平衡,使其适用于广泛的应用和硬件配置。它还依赖于从更大的教师模型中进行知识蒸馏。

运行 Gemma 3 需要什么硬件?

Gemma 3 设计用于在单个加速器上运行,例如 GPU、TPU 或专用硬件。Gemma 3 已针对 NVIDIA GPU、Google Cloud TPU 和通过 ROCM 的 AMD GPU 进行了优化。

在商业应用中使用 Gemma 3 是否安全?

Gemma 3 经过负责任地训练。在安全措施到位的情况下,Gemma 3 表现出低违规率和最小的有害能力。它还对滥用制造有害物质进行了特定检查,并得出结论认为风险很低。

什么是平移和扫描技术?

平移和扫描技术将图像切割成较小的裁剪区域以保留细节,并确保非方形格式的图像能够正确处理。它在处理带有文本的图像时特别有用,因此文本不会被截断。

相关问题

Gemma 3 与 Gemini 相比如何?

虽然两者都是 Google DeepMind 的产品,但 Gemma 3 是一种轻量级的开放 AI 模型,设计用于轻松部署,而 Gemini 是一种更强大、资源密集型的模型,适用于复杂的任务和应用。Gemma 3 借鉴了 Gemini 的研究,并进行了更高效的架构优化,以减少内存开销,并使在单个设备上运行 Gemma 3 AI 模型更加高效。Gemma 经过优化,遵循函数调用工作流,允许结构化输出。它能够处理 128k token 的上下文,以实现更实时和深入的输出。

在哪里可以下载 Gemma 3 模型?

Gemma 3 可以从 Kaggle、Hugging Face 或 Ollama 免费下载。如果您喜欢 Hugging Face,您可以在那里找到 Gemma 3。如果您更喜欢 Jax、Keras、Pytorch 或 VLLM,您也有这些选项。

相关文章